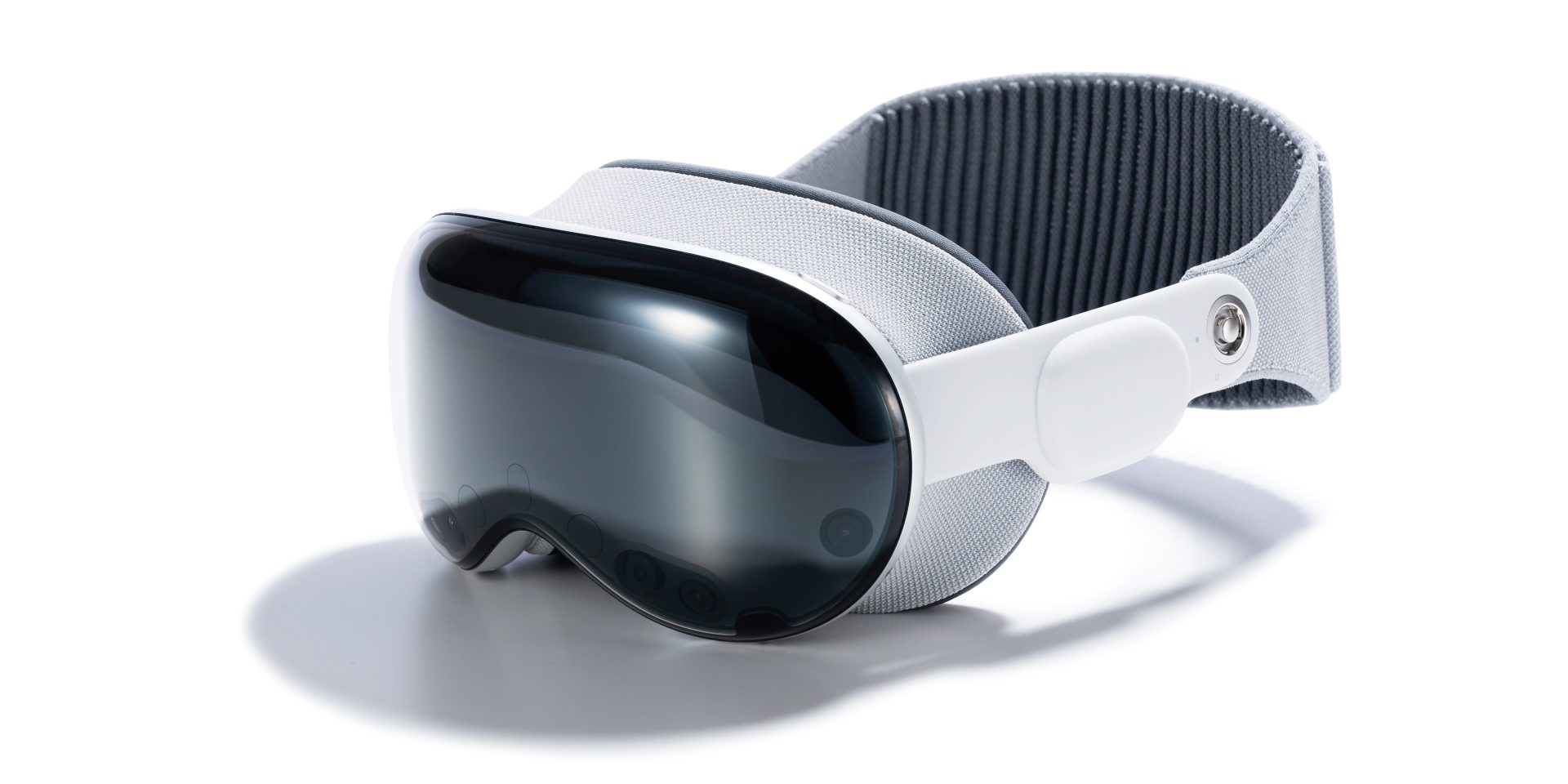

Vision Proの第2の心臓部

Vision Proには、Mac、iPhone、iPadには存在しない数多くのセンサやカメラなどが搭載されています。これらはVision Proが空間コンピューティングを実現するために必要不可欠ですが、従来のAppleシリコンにはこれらすべてを制御し管理する能力はありません。そこでAppleは、新設計のコプロセッサ「R1」をVision Proの空間処理のために開発しました。

R1が担う役割は、ユーザ周辺の現実空間を正確に把握し、メインプロセッサであるM2に必要な空間情報を提供することです。また、ユーザの視線やジェスチャを認識し、そのオペレーション情報をM2に提供する機能も備えています。

写真●https://www.ifixit.com/Guide/Apple+Vision+Pro+Chip+ID/169813

R1に求められるもっとも重要な性能は、リアルタイムかつ正確な空間処理能力です。というのも、空間認識とユーザへのフィードバック処理に遅れや誤差が生じると、ユーザはその体験にVR酔いなどの不快感を覚えてしまうからです。

また、現実空間とスクリーンに表示された空間に誤差や時間差が生じると、ユーザがVision Proを装着したまま移動する際に危険が生じます。空間フィードバックの精度と速度はVision Proにとって非常に重要な要素であり、それを実現するのがR1の役割なのです。

おすすめの記事

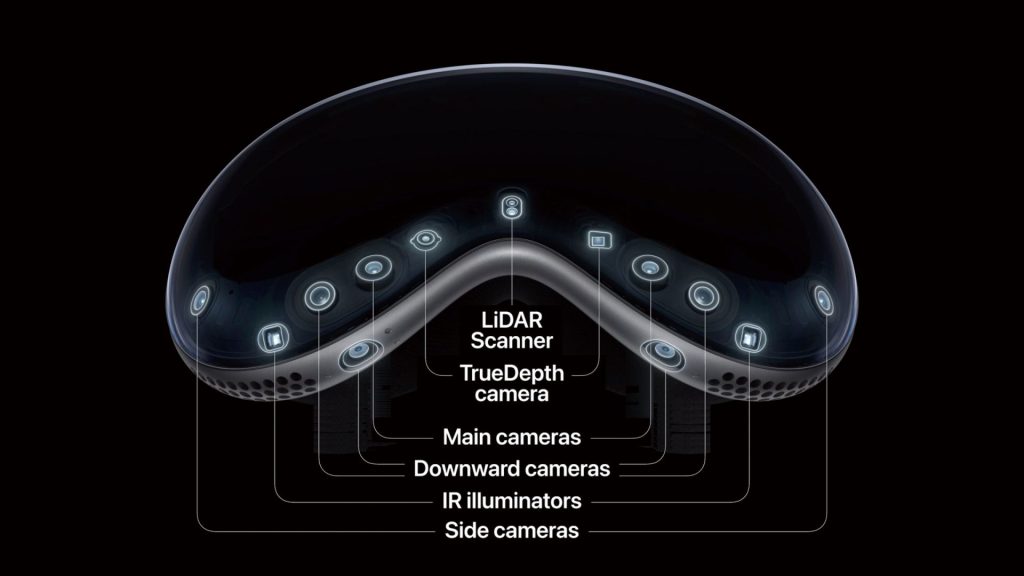

多数のセンサによる高精度な空間認識

Vision Proが搭載するカメラは、前方に2つ、左右に2つ、下部に4つ、さらにユーザ前方の空間を認識するためのLiDARスキャナとTrue Depthカメラを含めた合計10個。そして、6つのマイクと5つのセンサ類も搭載しています。

R1はこれらから収集した情報をリアルタイムに処理し、ユーザの周囲を取り巻く現実空間の正確な情報をM2に提供しているのです。

写真●https://www.ifixit.com/News/90137

さらに、M2はR1から得た現実空間を両目のディスプレイ上に展開し、そこにvisionOSが作り出した仮想空間を配置することで、ユーザにVision Proの優れた体験を提供しています。また、ユーザの目の動きや身振り手振りは搭載された多数のカメラやセンサによって検出され、それをR1が解析。その結果から得た必要なオペレーション情報をM2に提供することで、ユーザの意思が速やかにディスプレイ上に反映されるのです。

R1が現実空間の認識やユーザ操作の解析をM2に代わって処理することで、M2はアプリケーションプロセッサとしての処理に集中し、高いパフォーマンスを発揮します。Vision Proが持つ高品質かつ快適な空間コンピューティングの体験は、こういったM2とR1の緻密な連係プレイによって産み出されているのです。

写真●https://www.youtube.com/watch?v=GYkq9Rgoj8E

著者プロフィール

![フリーアナウンサー・松澤ネキがアプリ開発に挑戦![設計編]【Claris FileMaker選手権 2025】](https://macfan.book.mynavi.jp/wp-content/uploads/2025/06/C5A1875_test-256x192.jpg)