ローカル生成AIを楽しむためのMacの選び方【前編】では、エントリークラスのMacでも小規模なモデルであれば、それなりに実用的な生成AIをローカルで動作させることができることを解説した。

後編である今回は、ローカル生成AIを本格的に楽しむためにMacに求められる性能について解説する。

AIの「賢さ」を決めるメモリ容量

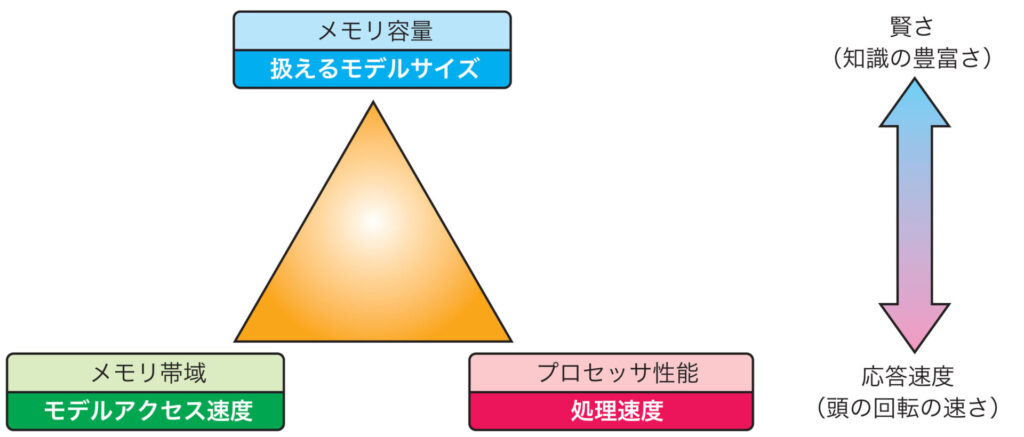

生成AIをローカル環境で動かすにはデバイスにさまざまなスペックが求められるが、その中で特に重要なのが、メモリ容量、メモリ帯域、そしてプロセッサ性能の3つだ。

その中でもAIの「賢さ」を決定づけるのがメモリ容量で、生成AIでは原則としてメモリ上に読み込めないサイズの学習モデルを利用することができない。

学習モデルには「パラメータ数」と呼ばれる指標があり、そのサイズが大きいほど豊富な知識を持ち、複雑な処理が行える。つまり、学習モデルのサイズはAIの「賢さ(知識の豊富さ)」の指標と言える。

Macにおけるローカル生成では主にCPUやGPUでその処理が行われるが、チャットボットのようなLLMでは「Metal」や「OpenML」などのAPIを使ってGPUで処理されるものが多い。

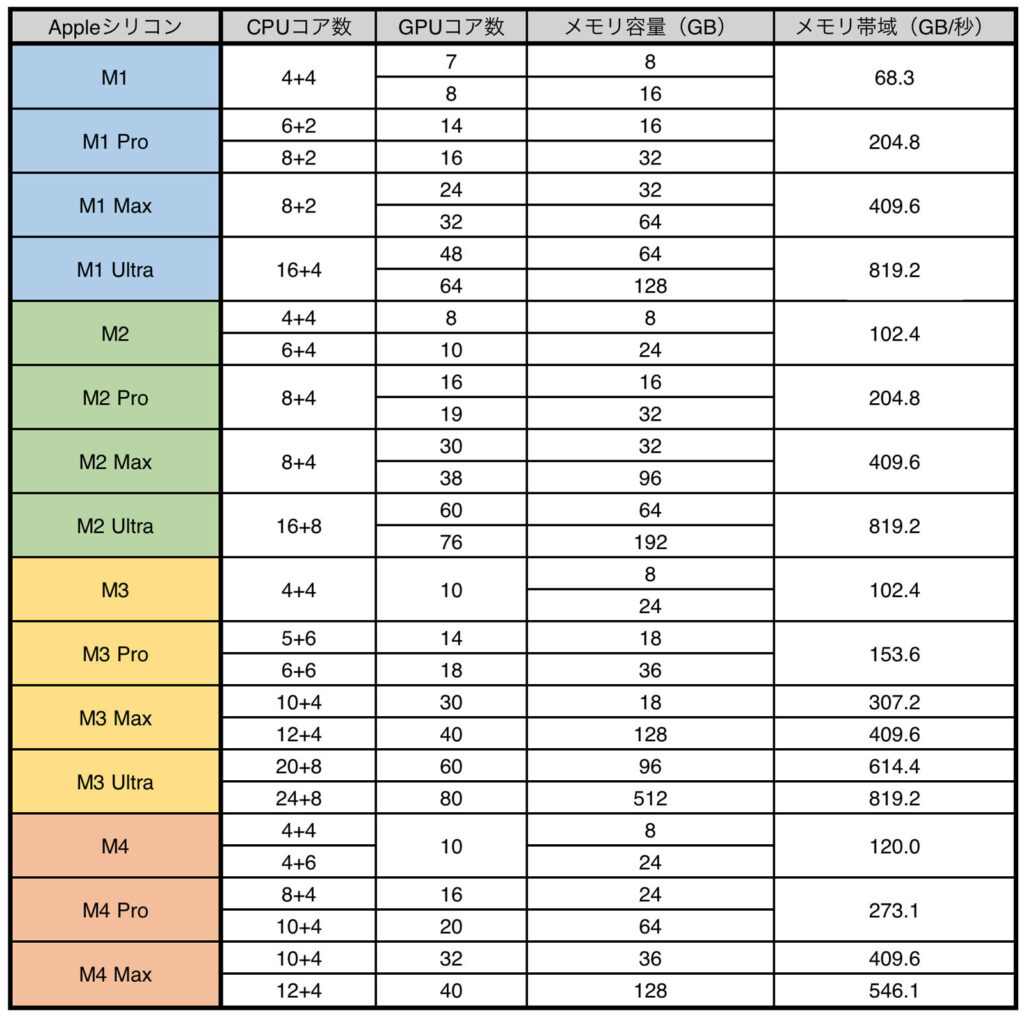

AppleシリコンはCPUやGPUなどのプロセッサコアがメインメモリを共有する「ユニファイドメモリアーキテクチャ」を採用するが、そのうちGPUには搭載メモリ容量の最大3分の2が自動的に割り当てられる(64GB以上のメモリを搭載したMacでは最大4分の3)。

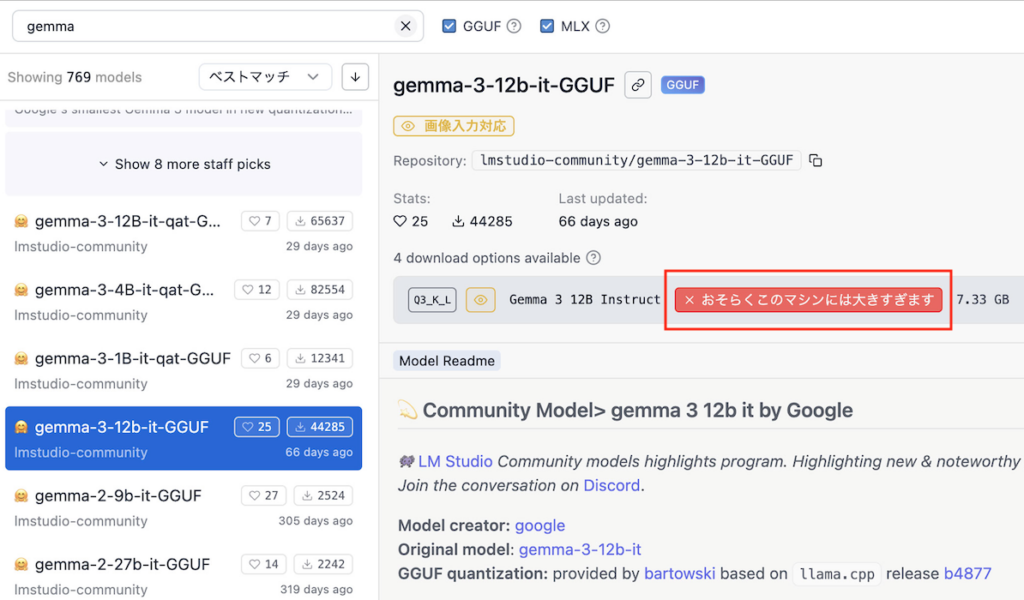

扱える学習モデルのサイズを確認するには?

ちなみに実際にGPUに割り当てられるメモリ容量は、デスクトップアプリ「LM Studio」を開き、「Hardware」→「Memory Capacity」→「VRAM」項目から確認することができる。

たとえば16GBのメモリを搭載したMacであれば、およそ10GBあまりをGPUに割り当てることができ、オーバーヘッド(20%程度)を考慮するとおよそ8GB程度までのサイズの学習モデルを扱うことができる。

つまり目的のモデルが扱えるかどうかは、Macに搭載されたメモリ容量で決まる。

Macのメモリ容量は購入時に決まり、後から増設することができないため、より大規模な(賢い)学習モデルを利用したいのであれば、十分なメモリ容量を持った製品、またはオプション設定を選択することが大切だ。

AIの「速度」を決めるメモリ帯域とプロセッサ性能

メモリ容量が生成AIの「賢さ」を左右する一方で、その処理速度、すなわち「AIの速さ」を決めるのがメモリ帯域とプロセッサ性能だ。

たとえば、チャットボットであれば言葉を投げかけてからレスポンスが返るまで。画像生成であればプロンプトを与えてから画像が完成するまでに要する時間を決定づけるのが、この2つの性能だ。

実際には2つの性能のうち低いほうで生成速度が決定づけられるが、そのバランスは学習モデルによって異なることから、一概にはどちらが重要とは言い難い。

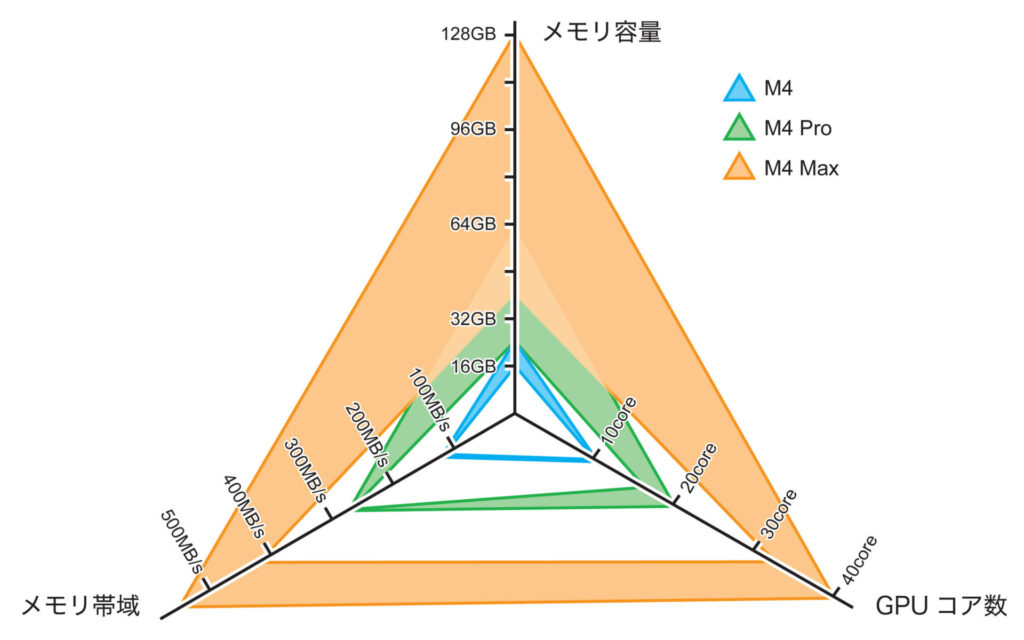

Appleシリコンはこの2つのバランスに優れたラインアップを持っているのが大きな特徴で、たとえばM4、M4 Pro、M4 MaxではGPUコア数に合わせてメモリ帯域(メモリチャンネル幅)がスケーラブルに拡張されている。

賢いモデルを使うには性能バランスが重要

デバイスに求められる性能は、学習モデルのサイズとも深い関係がある。

より賢い(パラメータ数が大きい)モデルは多くのメモリを必要とするが、同時にそのサイズに合わせて処理対象のデータが大きくなるため、コンパクトな学習モデルと同じレスポンスを得るには、より高い処理性能(メモリ帯域とプロセッサ性能)が求められる。

つまり、賢い(パラメータ数の多い)学習モデルを使うには、メモリ容量だけでなくそれに見合ったメモリ帯域とGPU性能が合わせて必要になるわけだ。

Macがローカル生成に適している理由

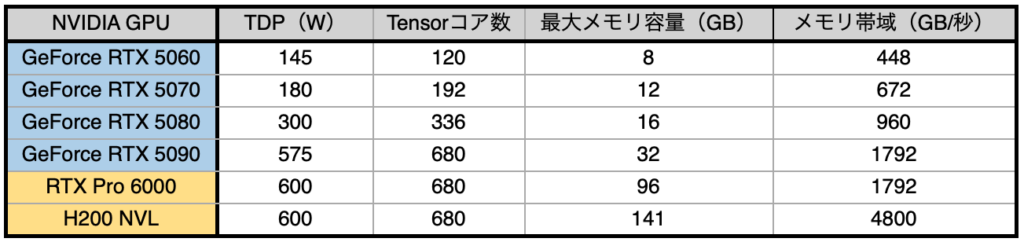

従来はNVIDIAのGPU一択だったローカル生成AI環境が、近年Macにも急速に展開されてきたのには理由がある。それはAppleシリコンが、優れたコストパフォーマンスとエネルギー効率を有するプロセッサだからだ。

NVIDIA製GPUの代表である「GeForce RTX 50」シリーズは極めて高いAI処理能力を持つが、一方で搭載メモリ容量とその価格が弱点だ。

最上位モデルの「GeForce RTX 5090」ですら最大メモリ容量は32GBで、これをPCに組み込むと100万円近いシステム価格になる。

一方、M4 Maxと36GBのメモリを搭載するMacBook Proは50万円あまりで手に入るうえ、オプションで最大128GBメモリを選択することも可能だ。

しかも、消費電力は「GeForce RTX 5090(GPU単体)」の5分の1程度と極めて省電力である。

大規模モデルも扱えるMacの実力

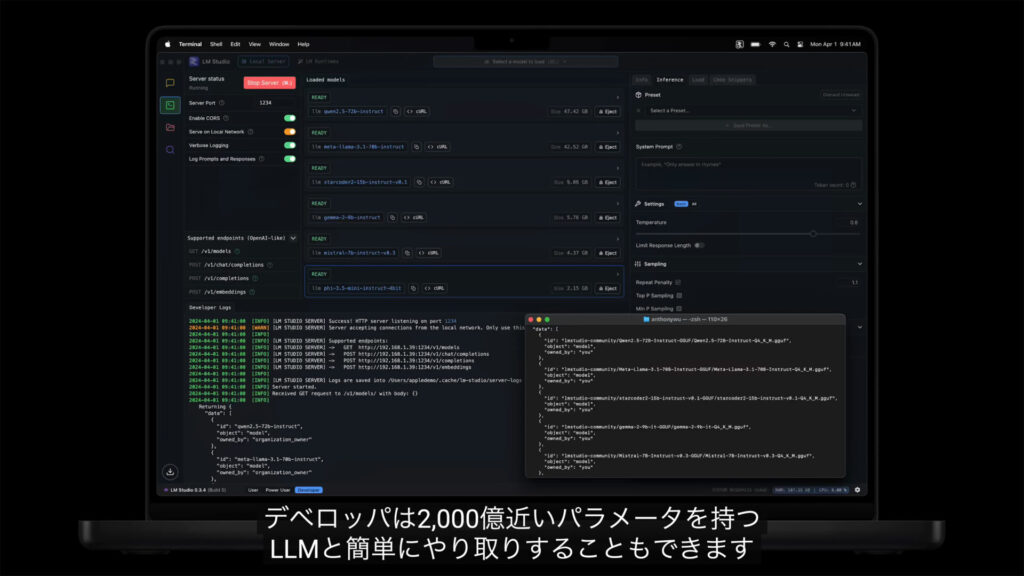

Appleは2024年10月のM4シリーズ搭載MacBook Proのリリースでも、大規模な学習モデルをローカルで動作させることができる点をアピールした。

さらに、2025年3月にリリースされたMac Studioでは、最大512GBのメモリと最大80コアGPUを搭載するモデルを準備し、「6000億以上のパラメータを持つ大規模言語モデル(LLM)を直接デバイス上で実行できる」と謳っている。

画像:Apple

このように、Macは個人ユーザでも比較的リーズナブルかつ手軽にローカル生成AIを扱うことができ、またそのことが、生成AIプラットフォームなどがMacへの対応を加速する要因になっている。

Apple IntelligenceやクラウドAI以外にも、現在のMacにはさまざまなローカル生成AIを楽しめる環境が充実してきているので、その醍醐味をぜひ一度体験してみてほしい。

おすすめの記事

著者プロフィール