「Apple Intelligence」が日本語対応したけれど、本格的なアシスタントになるのはまだ先

WWDC24で発表されたAI機能「Apple Intelligence」は、Appleデバイス上のOSに組み込まれてパーソナルアシスタントとして機能するのが特徴だ。4月には念願の日本語対応を果たし、対応デバイスのユーザはApple Intelligenceを体験できるようになった。

ただし利用できる機能はまだ限定的で、本格的なパーソナルアシスタントとしてフル活用できるようになるにはまだ時間がかかるだろう。

一方で、市場には「ChatGPT」をはじめとするチャット型の生成AIや「Stable Diffusion」といった画像生成AIなど、さまざまな生成AIが登場しており、すでにこれらのサービスを利用しているユーザも少なくないはずだ。

これらの生成AIサービスのほとんどはクラウド上のAIサーバで稼働し、ユーザはブラウザや専用アプリを使ってそのサービスを利用するスタイルが一般的である。

生成AIを手元で動かすメリットとは?

しかし、最近ではユーザデバイスの性能向上と、学習モデルをコンパクト化する「蒸留(Knowledge Distillation)」および「量子化(Quantization)」技術の進歩によって、ユーザの手元で生成AIを動かすことが現実的になってきた。

ローカル(オフライン)で生成AIを動かすメリットとデメリットは次のとおりだ。

メリット

- オフライン(インターネット非接続)での生成が可能

- セキュリティとプライバシーのリスク低減

- 自由度の高いカスタマイズ性

- クラウドサービスの利用料が不要

- 生成に(回数や時間などの)制限がない

デメリット

- 動かすデバイスの性能や仕様の制限を受ける

- 運用には(多少なりとも)知識が必要

- モデルの学習データが(クラウドより)古い場合が多い

ローカル生成AIはデータをインターネット上に送信せず、すべての処理をユーザの手元のデバイスのみで完結できる。これによって、個人情報の漏洩や不正アクセスのリスクを大幅に低減できるのが最大の特徴だ。

また一般的な従量課金制のクラウドAIサービスを必要とせず、無料サービスなどにおける利用回数や生成数の制限を受けることもないため、ユーザが好きなときに好きなだけ生成AIを利用することができるメリットは大きい。

ローカル生成AIの生い立ち

従来ローカル環境で生成AIを動かすには、NVIDIAのGPUを搭載したPCが必要だった。これは初期の生成AIのほとんどが、NVIDIAが開発した並列コンピューティングプラットフォーム「CUDA(Compute Unified Device Architecture)」上で開発されていたためだ。

「CUDA」はもともとNVIDIA製GPUをグラフィック以外の汎用計算に利用する「GPGPU(General-Purpose computing on Graphics Processing Units)」技術として開発され、シミュレーションなどの科学技術計算やマイニングに代表される暗号処理などに利用されていた。

しかし、その優れた並列処理能力がディープラーニング(深層学習)に適していたことから、AI向けのプラットフォームとして爆発的に普及した。現在ではクラウド上で稼働するAIサーバの大半が同社のGPUで構成されていると言われている。

そのCUDAプラットフォーム上で開発された生成AIが、この数年でほかのプラットフォームにも展開が進んだ。

たとえば、Mac向けには「Metal」や「Open ML」などのAPI上で動作するAIプラットフォームが続々と登場している。これはAppleシリコンのアーキテクチャが生成AIを動かすのに適した特性を持っているからだが、その詳細については別の記事で詳しく解説したい。

M1搭載MacBook Airでも動く、ローカル生成AI「LM Studio」を試してみた!

では実際にAppleシリコン搭載Macで動く、ローカル生成AIの実例をいくつかご紹介しよう。多くの読者の方に体験してもらえるよう、検証にはメモリ8GBのM1搭載MacBook Air(2020)を使った。Appleシリコンでは最小構成と言える環境なので、このMacで動かせれば、ほとんどのMacに対応するはずだ。

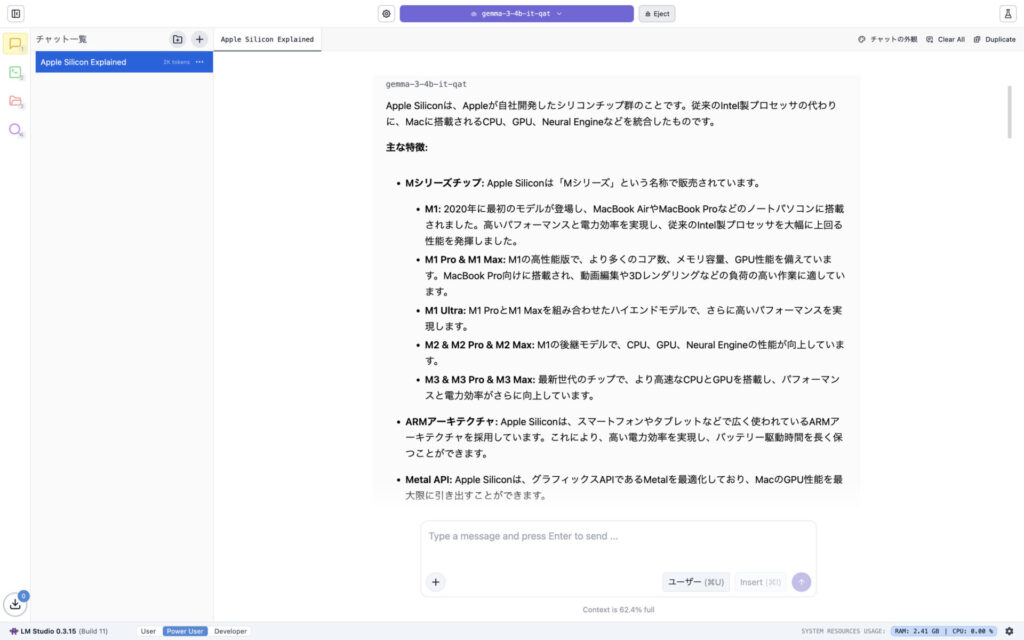

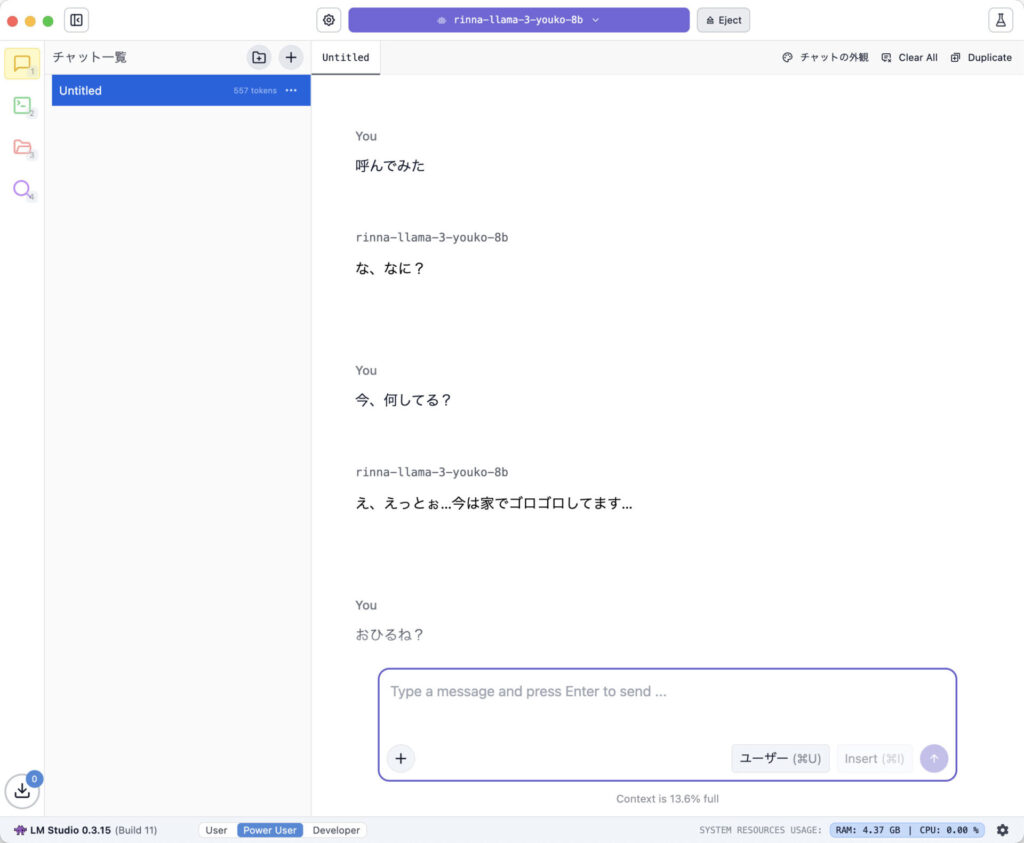

まず最初は、「LLM(Large Language Model、大規模言語モデル)」をベースにしたチャットボットを紹介する。プラットフォーム(ユーザが操作するデスクトップアプリ)には「LM Studio」を使った。

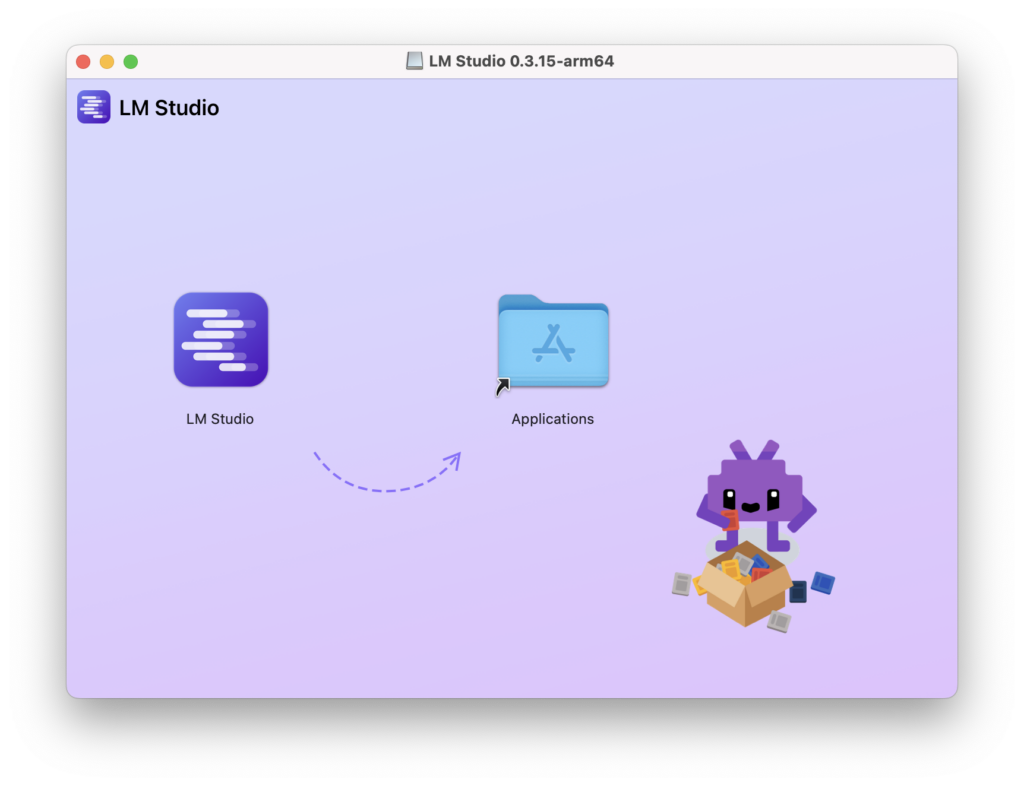

「LM Studio」はPythonなどの専門知識がなくても使える容易さと、上級者向けに細かいチューニングを行える豊富な機能を兼ね備えたLLMの実行環境で、Mac版だけでなくWindows版やLinux版も存在する。

Macに「LM Studio」をインストールしよう

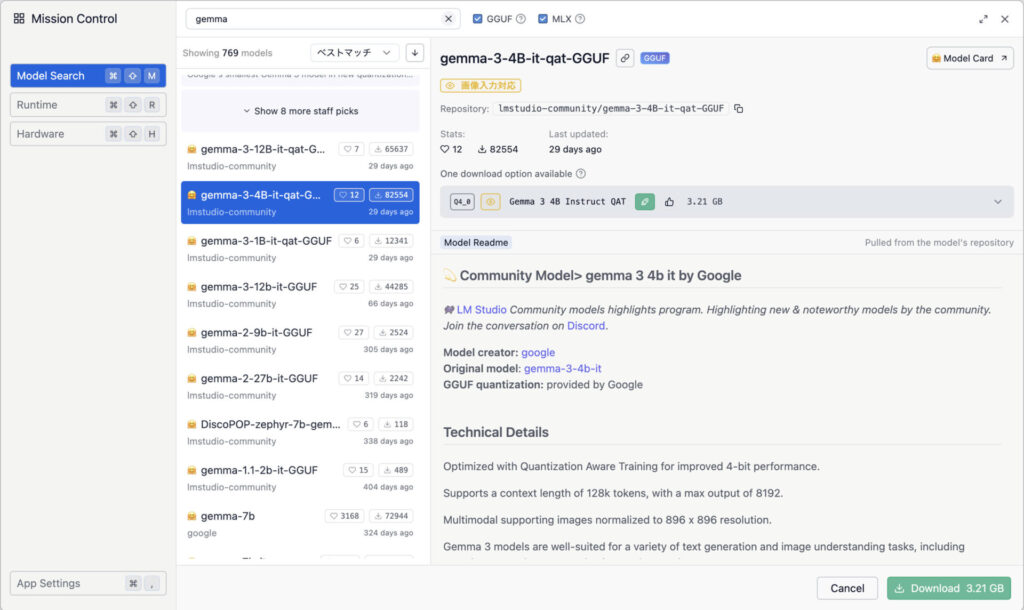

「LM Studio」をインストールして起動し、LLMの学習モデルを選んでダウンロードする。ダウンロードしたモデルをロードすれば、ただちにチャットできるようになる。ここではタイプの異なる2種類のモデルを選んでみた。

「Gemma」は、メモリ容量が少ないMacでも動かせる!

1つはGoogleが開発した生成AIモデル「Gemini」から派生した軽量でオープンソースの生成AI「Gemma」で、ChatGPTやGeminiなどに触れた経験があれば違和感なく使えるはずだ。パラメータサイズが異なるモデルが用意されており、メモリ容量が少ないMacでも動かせる。

「Rinna」は、女子高生とチャットで日常会話をしているみたい!

もう1つは10年前にMicrosoftのプロジェクト「女子高生AI りんな」からスタートし、今はrinna株式会社で開発と製品化が行われている日本語特化型AIモデル「Rinna」を試してみた。

画像生成AI「Draw Things」を使って、Macでイラスト生成してみよう!

「LM Studio」はチャットAIに適したプラットフォームだが、同様に画像生成AIを動かすためのプラットフォームも存在する。

このジャンルでは「Stable Diffusion」が有名だが、Macへの導入にはパッケージ管理ツールやプログラム言語(Pythonなど)をインストールする必要があり、CUIでのオペレーションが主体となることから初心者には敷居が高い。

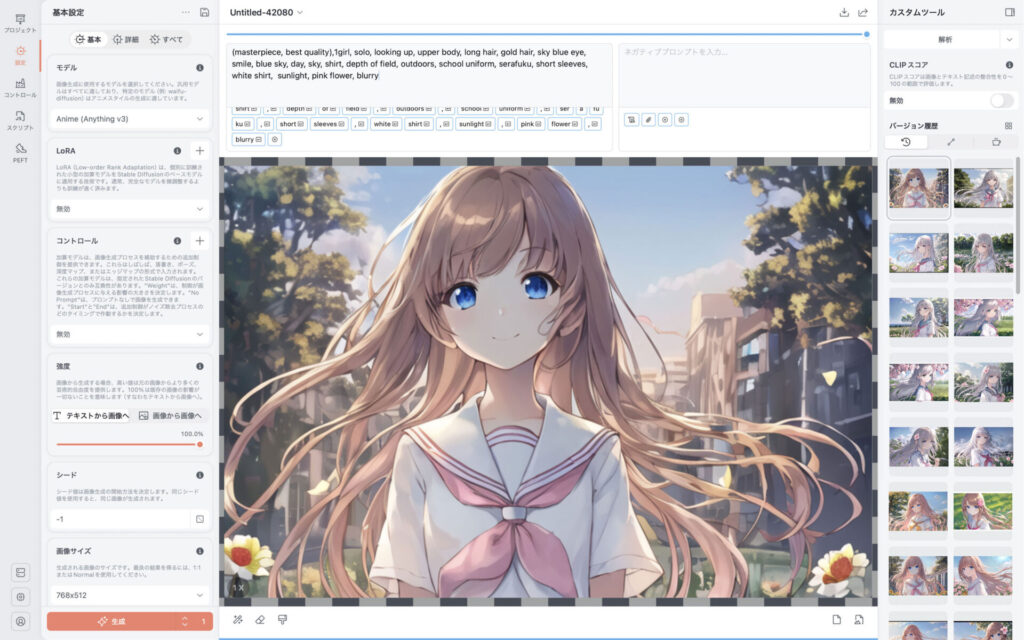

そこで「LM Studio」のように好きなモデルをダウンロードして実行できるGUIベースのプラットフォーム「Draw Things」を使ってみた。このアプリはmacOSのApp Storeから簡単に導入することができる。

「Anime(Anything v3)」で“日本アニメ調”のイラストを生成してみた

今回は試しに、Apple Intelligenceの画像生成機能「Image Playground」では難しいとされる日本アニメ風のイラストを生成させてみることにした。

「Draw Things」はイメージの特徴を「プロンプト」という複数のワードで指定することで、生成されるイメージをコントロールすることができる。

また原画(画像)を読み込ませて、プロンプトを使って再生成させることも可能だ。今回は日本アニメ調イラストの生成に向いているとされる「Anime(Anything v3)」というモデル使い、プロンプトのみで「女子高生」風のアニメ調イラストを生成してみた。

「Apple Intelligence」では生成が難しい画風のイラストも、エントリークラスのMacで作れちゃう!

このようにエントリークラスのMacでも、小規模なモデルであればある程度実用的な生成AIをローカルで動作させることができる。

インターネット上のクラウドAIとはまた違う世界がそこにはあり、目的や用途によってオンラインサービスと使い分けることで、生成AIの可能性を拡張できるはずだ。

次回は、ローカル生成AIを本格的に楽しむ上でMacに求められる性能についてご紹介しよう。

おすすめの記事

著者プロフィール