【Siri】ユーザのプライバシーを配慮した もっとも身近で安全なAIアシスタント

Apple製品に組み込まれたAI技術は、実にさまざまな部分に及んでいる。しかし、ユーザがもっとも身近に感じ、「AppleのAI」という言葉から直接的に想起されるのは、音声アシスタントの「Siri」だろう。

当初は気恥ずかしく思えた音声による呼び出しも、慣れれば特定の処理や操作を迅速に行える手段として定着しつつある。ある調査によれば、既存の操作方法と比べた場合、Siriを利用することで、検索は2倍、ツイートなどの投稿も2倍、アラームのセットは4倍速くなるという結果が出ている。また、2015年の時点でSiriに対する問いかけが、すでに週あたり10億回に達していたことをAppleが明らかにしており、その後も順調に利用頻度が高まっていることは予想がつく。

Siriは元々、SRI(スタンフォード大学研究所)の国際AIセンターにおける研究から生まれた技術を源流とし、その研究者たちがスピンアウトして設立したソフトハウスにより、iOS向けにリリースされた音声アシスタントアプリがベースとなっている。Appleは、そのアプリを企業ごと買収し、改良を加えてOSレベルの機能として組み込んだのだ。

Siriの名称は、「Speech Interpretation and Recognition Interface(発話解析・認識インターフェース)」に由来しているが、実際には認識したあとに行える処理の幅広さがユーザにとっての最大のメリットとなるため、認識精度の向上とともに、バックエンドのサービスをいかに充実させるかにバージョンアップのポイントが置かれてきた。

当初、SiriはiOSデバイスのホームボタンを押して呼び出す方式だったが、進化の過程で、"Hey Siri"の起動ワード(ウェイクワードともいう)によってハンズフリーで使えるようになった。それにより、料理や運転中で手がふさがっているときにも使いやすくなり、利用範囲が広がったが、このことは音声によるインタラクションが将来的なユーザ体験において重要な位置を占めることを、Apple自身が強く認識していたからにほかならない。

にもかかわらず、スマートスピーカの分野で出遅れたのは、近年の同社が、iPhoneをはじめ既存のスマートデバイスの成功体験から抜けきれなかったためともいえる。これに対して、スマートデバイスの足がかりがなかったAmazonは、2014年に自社ブランドのスマートフォン「Fire Phone」を発売するとともに、スマートスピーカである初代「Echo」の試験販売を開始したものの、前者が完全な失敗に終わったことから、不可避的に後者に注力する流れとなった。

iOSのSiriは2014年にソフト的な対応で充電時の音声起動を可能とし、Echoの一般販売が開始された2015年にハードの改良で常時音声起動をサポートしたが、その間に、スティーブ・ジョブズ氏の何らかのひらめきと指示があったとしても、あながち間違いではないように思う。いずれにしてもSiriは、今後の同社のビジネス戦略において非常に重要な位置づけにある。それは純正のARグラスのような、物理的な入力インターフェイスが適さないウェアラブルデバイスが、やがてスマートフォンに取って代わるような世界に備えているためと考えられよう。

そのためにも、Appleが重視するのは、Siriが扱う情報のプライバシーである。GoogleやAmazonが、検索やスマートスピーカから得たデータを究極的には広告関連事業のマーケティングに利用したり、自社のEコマース事業の拡大に活用しているのに対して、Appleは得られた情報をSiri関連の技術やユーザ体験の向上以外の目的では使わないことを明言している。そのため、他社のAIアシスタントと比較して、できることが限られたりもするが、その分、安心して使える技術になっているのだ。

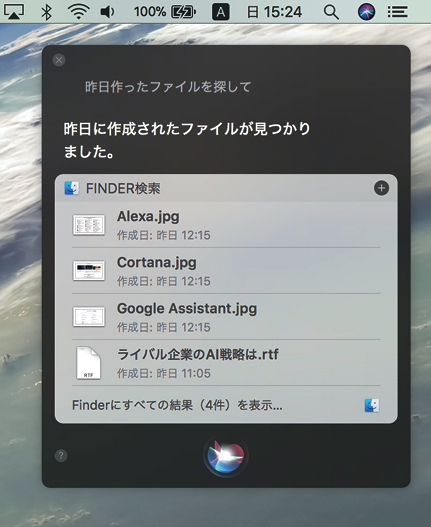

Siriは、今ではmacOSにも組み込まれ、OS自体の機能の違いから、さらに細かい作業を指示できる。また、アクセシビリティの設定次第で、Siriを音声ではなくタイプ入力でも使える。iOS 11でも、Siri起動後にタイプ入力が可能となったが、どちらも基本は音声入力だ。

Siriのテクノロジー(1) 安全で効率的な音声認識

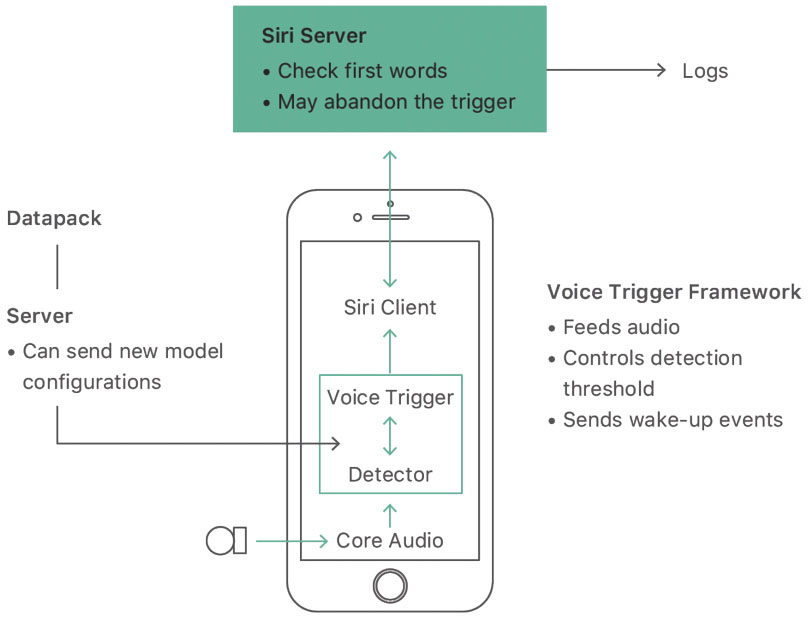

Siriは、iOSデバイスでは2015年のiPhone 6sとiPhone 6s Plus以降、常時、"Hey Siri"の起動ワードによって、ハンズフリーで使えるようになった。そのため、スリープ時も含めて周囲の音を聞き取る必要があり、プライバシーの問題が懸念されたが、Appleは2段階の措置を講じている。

まず、起動ワードが発せられるまでは認識処理をデバイス上でローカルに行い、音声を保存も送信もしないことで聞き取りを「その場だけ」のものとした。

しかし、本格的な音声認識と意味解析や、それ以降の処理には、それなりの処理パワーとネット上のリソースが必要となる。そこで、ユーザの質問や要求部分の音声は暗号化され、匿名のSiri IDとともに遠隔地にあるSiriサーバに送られて、個人が特定されないようにクラウド上で処理されるのだ。

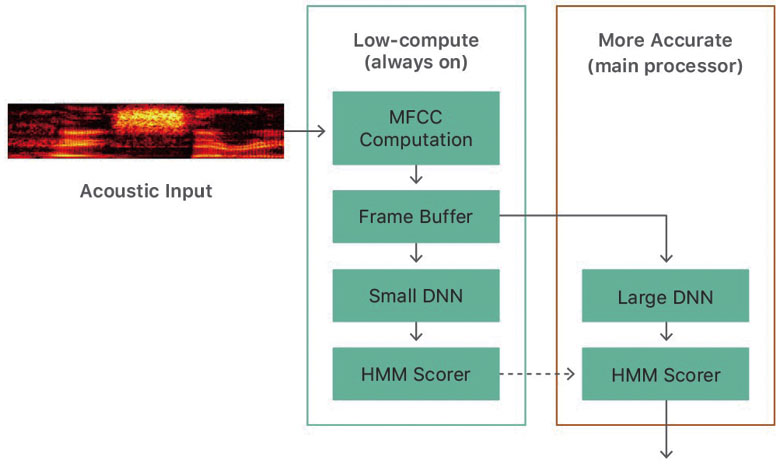

また、モバイル機器で、スリープ時も含めて常に起動ワードを正確に聞き取って認識し続けるのは、処理の負荷や電力消費の点で辛い。そこでAppleは、大まかな認識しかできないが超低消費電力のAOP(オールウェイズ・オン・プロセッサ)をモーションコプロセッサ内に組み込み、その認識結果があるを超えると、はじめて消費電力の大ききなメインプロセッサで詳細な認識を行うことで、バッテリの持ちと正確な処理を両立させている。

Siriの音声認識は、Core Audioを介して入力された音声に起動ワード(Hey Siri)が含まれるかをDetectorが判定し、含まれていれば、続く音声が暗号化・匿名化され、サーバに送られて処理される。【URL】https://machinelearning.apple.com/2017/10/01/hey-siri.html

起動ワードの認識は2段階で行われ、まず常時聞き取りを行う低消費電力のAOPというプロセッサが初期の判定を行い、ある閾値を超えるとメインプロセッサでより厳密に判定される。

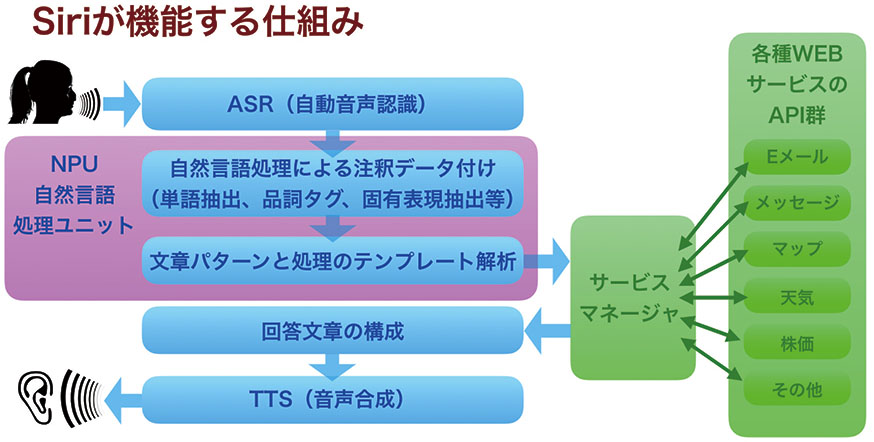

Siriのテクノロジー(2) 高度な自然言語処理

音声認識は「音声をテキスト化するところまで」であり、その結果として得られた文章の意味を理解するためには、まったく別のプロセスが必要となる。それが、自然言語処理だ。

自然言語処理は、さまざまな要素が絡み合う複雑なもので、大きく分けて、単語分解、構文解析、意味解析の3つの部分から構成される。単語分解では、大量の辞書データや文法ルールを用いて文章を品詞単位に分解する。次に、この品詞情報を基に文章内の係り受けの関係を判別し、文章構造が解析される。そして、改めて大量の類義語や反義語の辞書データや統計解析的な手法を使い、出現語のグルーピングや関連度の計算を行って、その文章が意味するところを明らかにしていく。

Siriでは、一問一答形式でのやりとりが基本となるため、特に質問や意思・意図を示す部分を明確化し、天気やニュースといった外部の情報ソースに照会したり、予約サイトなどのWEBサービスに送信して結果を返してもらう。そして、得られた生の情報を、自然な文章に変換し、音声合成技術によってユーザに伝えるのである。

あの短いやりとりの間に、これだけの処理が行われ、しかも、要求が世界中のユーザから途切れることなく送られてくることを考えると、それを支えるインフラの膨大さがわかるはずだ。

Siriが応答可能な質問の内容は、OSのバージョンアップとともに拡大し複雑化しており、それを支える自然言語処理能力も高まってきた。高度な処理が行えるのも、サーバ側で対応しているためだ。

音声認識後の実際の意味解析は、ピンク色の領域内にある自然言語処理系で行われ、その結果がサービスマネージャに送られて、対応するアプリやサービスに照会。得られた答えを合成音声で返される。右の図はスタンフォード大学の自然言語処理コースの資料を基に作成。

【パームリジェクション】地味ながら重要な「ただ機能する」ための役割

Appleの考えるAIの利用法は、Siriのように存在感のあるアシスタント的な機能だけではない。ともすれば、見過ごしてしまうような些細な、しかし、それがなくなってはじめて重要さに気づくような部分にも投入されている。

その最たるものが、iPad ProでApple Pencilを使って絵を描くときのように、タッチスクリーン上に手のひらの一部を置いた状態でメインのタッチ操作を行う際に、それ以外の接触箇所の入力を無視する「パームリジェクション」機能だ。あまりに自然に行われるこの処理は、実際にはApple Pencil以外のスタイラスでも有効なため、基本的には接触面積や形状をAIによって判定してリジェクトするかを決定し、Apple Pencilの場合には、さらにスクリーンからわずかに浮いた状態でも認識されることを利用して、さらに精度の高いリジェクションが実現されているものと考えられる。

さらに、このパームリジェクションは、大きなタッチサーフェスを持つ、MacBookファミリーやMagic Trackpadのマルチトラックパッドにも実装されており、たとえば手のひらを当ててスワイプしてもポインタ移動やスクロールなどは起こらない。AIは、このようにして日常的な操作のサポートを行っているのである。

【画像認識】撮影した人物やシーンの分類から思い出のリマインドまで

iPhoneをはじめとするスマートデバイスの普及により、今や世界中の人々が、人類史上でもっとも写真を撮る時代に突入した。その結果、未整理の写真データが溜まる一方という状況が常態化しつつある。そこで、iOSとmacOSの「写真」アプリでは、登録されたイメージが自動的に解析され、撮影場所ごとはもちろん、被写体の人物ごと、あるいはシーンの類似性に基づく分類が行われるようになっている。このため、AIは1枚の写真に対して実に110億回もの計算を行って、そこに写っている物体や風景を把握し、たとえば動物の種類や海・山・空といったシーンの属性に応じて仕分けをしてくれるのである。

もちろん、はじめて被写体として写り込んだ人物の名前までは、さすがのAIも特定できず、その点はユーザが補う必要がある。また、横顔や後ろ向きの人物の判定は、近しいユーザの目からは可能でも、まだAIには難しかったりする。しかし、そういう場合にAIは、ユーザに該当イメージを表示して判断を求める賢さも備えている。

さらに、iOSデバイスでは、写真撮影の際に最適な露出やシャッタースピードを、光の状態や被写体の移動速度などから割り出し、ベストな1枚に仕上げるのもAIの仕事なのだ。

iOSやmacOSの写真アプリには、人物の顔や風景内に写っている物を見分けて自動分類する顔認識やシーン認識の機能が備わっているが、これらの処理でイメージ解析を行うのもAIの役割だ。さらには、位置情報や写っている人物から自動で思い出のアルバムやスライドショーまで作ってくれる「メモリー」機能も実現した。

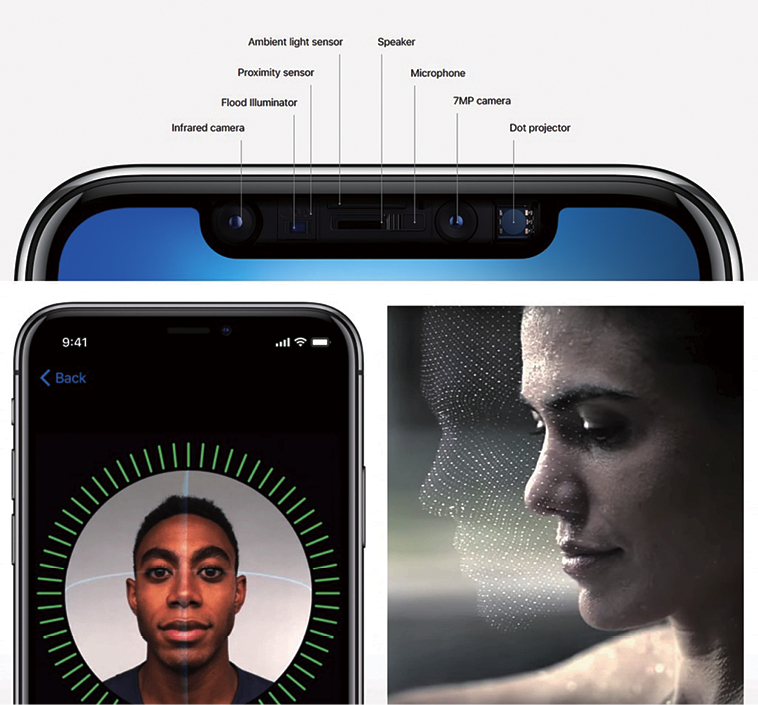

【顔認証】“スマートフォンの未来形”に搭載された世界でもっともセキュアな個人認証技術

AIは、人間では処理が追いつかないような膨大なデータの照合を瞬時に行えることから、サイバーセキィリティの分野でも活躍が期待されている技術分野だ。今後の企業戦略の大きな柱として、セキュリティの高さを据えようとしているAppleも、ユーザの個人情報を守り、安心して使えるプラットフォームを確立することが、デジタル化社会におけるビジネスの維持に不可欠と考えている。そして、この分野でのAIの応用にも積極的に取り組んできた。

その身近な成果がiPhone Xで採用された顔認証技術のFace IDであり、指紋認証のTouch IDに比べて、20倍もセキュアであるとAppleは主張している。

GoogleやAmazonと異なり、ユーザの写真データを自社のクラウドサービスから収集していないAppleは、認証学習のための顔データに実在の人物のものを利用できない。そのため、学習用の無数の顔データ自体をAI技術を利用して作り出すことまでして、Face IDを熟成させた。また、顔の照合も、自社開発のA11 Bionicチップ内のニューラルエンジンを利用してローカルに行うことで、個人情報を守る姿勢を明確に打ち出している。これも、セキュリティの高さがユーザメリットにつながると信じているためだ。

幅広く展開されるAppleのAI活用 自動運転技術開発は実現するの?

Appleの自動運転車プロジェクトは、一時は、立ち消えになったかと思われたが、実際には2017年からテスト車両が目撃されるなど、開発は粛々と継続されている。

先ごろ、その中心的技術に関する論文も発表され、AI関連のイベントでも、非公開のワークショップが開かれるなど、外部へのアピールも活発化してきたのが、この分野だ。

ポイントとなる技術は2つあり、1つ目は、パルスレーザー光を使った測距システムである「LiDAR(ライダー)」から得た生のデータをそのまま使い、路上の歩行者や自転車、障害物などを見分けることが可能な「VoxelNet(ヴォクセルネット)」という3Dオブジェクト認識技術。認識のための前処理が不要となり、システムリソースの低減や処理の高速化が期待できる。

もう1つは、カメラの画像から、複数の物体を見分けて分類したり、その位置を精密に把握できるビジュアルSLAM(simultaneous location and mapping)技術。これは、自動運転車のみならず、ロボティックスやAR/VRの分野でも有効な処理技術だ。

自動運転車は話題としても派手なだけに注目されがちだが、Appleはより幅広い応用を考えているものと思われ、実際にどのような製品に結実するかは、今後の市場動向次第ともいえる。

自動運転技術を開発するボヤージュの共同創業者、マッカリスター・ヒギンズ氏が遭遇したAppleのテストカーに搭載されたメカは、全要素が屋根上のユニット内で完結している。

Appleは、生の3Dポイントデータから直接路上の物体を見分けるVoxelNetと呼ばれる3Dオブジェクト認識技術を実用化しつつある。【URL】https://arxiv.org/pdf/ 1711.06396.pdf

【HomePod】日本国内での発売が待たれる遅咲きのApple流スマートスピーカ

いよいよ米・英・豪での販売が始まったSiri搭載のHi-Fiスピーカ、HomePod。日本語モードのiPhoneを使った初期設定時に、日本語に対応したら知らせる旨のメッセージが表示されることから、国内販売に向けての準備も進められているようだ。

現状では、日本語よりも流暢な英語によるSiriのメッセージが流れると、その優れた音質と相まって、iPhone以上にAIが人間に近い存在として感じられる。しかし、実際の開発はAmazonのEcho以前からハイエンドのオーディオスピーカとして始まり、途中からAIスピーカとしての性格を強めたこともあり、Apple自身は「スマートスピーカ」とは呼んでいない。

確かに、Appleがサードパーティに求めるセキュリティ基準の高さから、Siriでコントロール可能なHomeKit対応デバイスはライバルよりも少なく、HomePod向けの音声アプリ開発環境も公開されていないが、日常的によく使われる天気やニュースの読み上げなどには(英語だが)対応できる。

おそらくAppleは、既存デバイス以上に音声への依存度が高いスマートスピーカのユーザ体験の在り方を依然模索中(左ページの他社動向参照)であり、それが確立されれば、HomePodの機能や応用範囲を広げ、アプリ開発も推進するものと思われる。

【ポートレートライティング】誰もが使えるプロのフォトテクニック

iPhone Xのカメラアプリでサポートされたインカメラの「ポートレートライティング」機能は、顔の3D形状をTrueDepthカメラで把握し、AIを使ってスタジオ撮影並みのライティングをシミュレートしたり、背景のぼかしや暗転を行い、被写体の人物を際立たせる効果を作り出す。

従来の2つのレンズを利用したアウトカメラのポートレートモードでは背景のぼかしのみだったが、ポートレートライティングではさらに高度な写真表現のためにAIが利用されており、Appleらしい技術の使い方となっている。

【バッテリの寿命管理】利用パターンを解析しバッテリを長持ちさせる

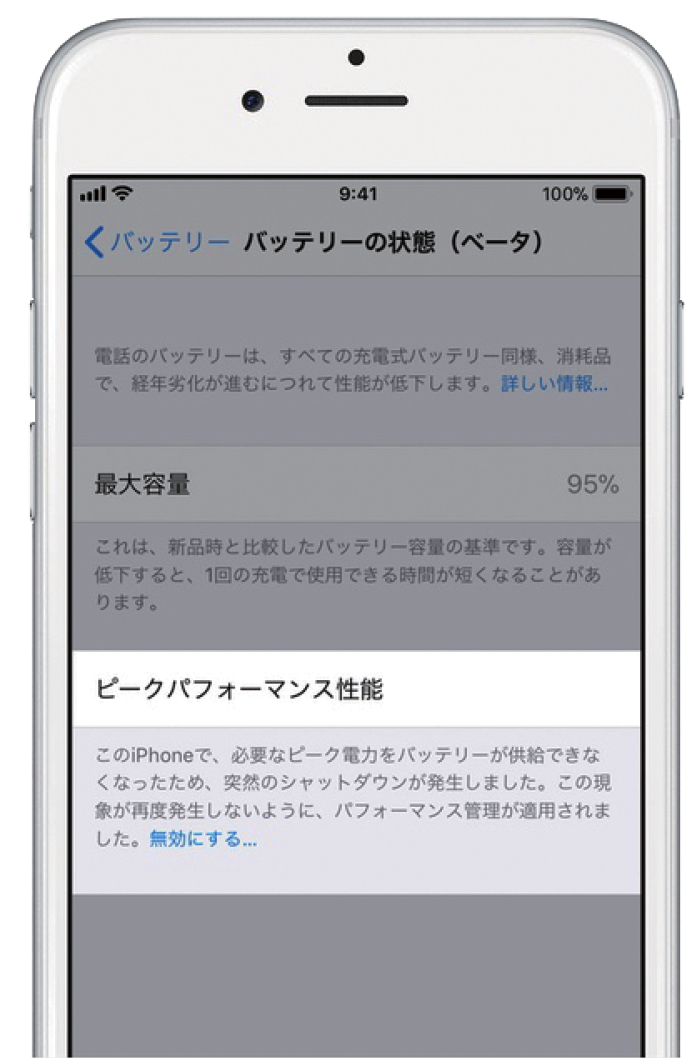

先ごろ問題となった、iPhoneのバッテリ劣化時にピークパフォーマンスを自動的に低下させ、不意のシャットダウンを防ぐ機能は、その事実を公開していなかった点にAppleの落ち度がある。しかし、その処理自体はアプリのデータを守るなど、ユーザメリットを考慮したものだった。

こうした処理を行う判断や、ユーザの利用パターンに応じてバッテリを長持ちさせるように省エネ機構を調整することも、AIの大切な役割の1つである。このように、通常は意識されにくい裏方的な機能にもAppleのAI技術が投入されているのだ。

AIは、iPhoneのバッテリを長持ちさせるためのユーザの利用パターンの解析や、バッテリの劣化に伴う突然のシャットダウンを避けるためのパフォーマンス管理にも応用される。図は、iOS 11.3に実装予定のバッテリ管理画面。

AI時代の覇権争いはこれからが本番

ライバル企業が展開するAI活用

先行する「エコー」シリーズ

少し前まで、電子機器を巡る各社の攻防のキーワードは「モバイルファースト」だった。それが今では「AIファースト」が合言葉となり、ビッグデータ解析から市場や消費者の動向を把握してビジネスに活かしたり、顧客の嗜好に合わせたサービスを行うためにAIを活用できない企業は、競争から置いていかれようとしている。

その利用法は、ここまで見てきたように、縁の下の力持ち的なものも多い。そして、IBMやグーグルといったIT界の巨大企業はエンタープライズやリサーチ分野向けのAIソリューションを提供し、人知れず社会の役に立っていたりする。

一方で、人間との直接的な接点という意味でGUI(グラフィカルユーザインターフェイス)の次に来るものとして注目されているが、VUI(ボイスユーザインターフェイス)であり、特に消費者をAIベースのエコシステムに引き込む手段として台頭したのが、スマートスピーカだ。

業界ではじめてこの分野の製品を市場投入したのはEコマースの巨人・アマゾンであり、同社のAIアシスタントである「アレクサ(Alexa)」をサポートした「エコー」シリーズによって、市場の7割を押さえているとされる。また、同社はより小型で安価なモデルから小型ディスプレイ付きのモデルまで製品ラインを拡充し、応用分野を着々と広げつつある。

そして、サードパーティからもアレクサ対応のスマートスピーカやほかの家電製品が発売され、声でアマゾンの取扱商品を注文できたり、「アマゾン・ミュージック(Amazon Music)」や国によって異なるほかの配信サービス(日本では、auの「うたパス」とNTTドコモの「dヒッツ」)を利用した音楽再生が可能となっている。

このエコーを追う存在が、グーグルの「グーグル・アシスタント(Google Assistant)」に対応する「グーグル・ホーム(Google Home)」であり、小型の普及モデル「グーグル・ホーム・ミニ(Google Home Mini)」やホームポッド対抗の「グーグル・ホーム・マックス(Google Home Max)」を加えてシェア拡充を狙っている。その強みはやはり検索機能にあり、VUIの特性上、答え方は簡潔だが、ウィキペディアの比重が大きいエコーよりも検索対象が広い。音楽再生は自社の「グーグル・ミュージック(Google Music)」や「スポッティファイ(Spotify)」、それに加えて日本では「うたパス」を利用可能だ。グーグルは、アマゾンのようにEコマース部門を持たないが、世界最大の小売りチェーンであるウォルマートなどと提携して、商品注文にも対応(日本では未対応)している。

完全な覇者はなく伏兵が潜む

シリで先行したアップルも、スマートスピーカ開発では遅れをとり、PC界の覇者だったマイクロソフトのAIアシスタント「コルタナ(Cortana)」も、対応スピーカがハーマン・カードンから発売されつつ、肝心のウィンドウズ10上の利用が伸び悩み、PCメーカーは独自にアレクサのサポートに踏み切るところが目立っている。

こうした流れの中、確かにアマゾンは先行したものの、ホームポッドを含めて、それぞれ得意不得意があり、現時点ではこれ1台で万能というAIアシスタントやスマートスピーカはない。検索に秀でたグーグル・アシスタントに至るまで受け答えに詰まるような質問も無数にある。

加えて、日本では同義語の多さやVUIのための対話シナリオ設計が多くの開発者にとって未知の領域であるため、スキルやアクションの開発に苦労しているようだ。このあたりの対策を固めるために、アップルはホームポッドアプリの開放や日本での販売開始を遅らせている可能性もある。

また、LINEの「クローバー(Clova)」シリーズや、2018年5月にもリリースされるというフェイスブックのスマートデバイスなど、メッセージングやSNSを通じて独自の強みを持つ企業の参入も相次いでおり、この分野の覇権争いは、これからが本番といっても過言ではないだろう。

AmazonのAlexaは、スキルと呼ばれる対応アプリの充実に大きな特徴があり、世界では3万以上、日本でも執筆時の公式ページ上では265だが、実際には450以上で更新が間に合わないほど急速に増えている。

Google Assistantも、アクションと呼ばれるサービスを利用できるが、もっとも得意とするのはやはり音声検索である。ただし、音声UIの特性に合わせて、結果はなるべく短く端的に伝えようとする。

MicrosoftのCortanaは、Windows 10に搭載されたSiri的存在だが、利用率はそれほど高くない。先ごろAlexaとの連係を発表し、互いに不足する領域を補完することにしたが、どちらもモバイル領域での存在感が薄い。