iOS 11で導入された新しいフレームワーク「ARKit」によって、ARが再び脚光を浴びている。そのARの基幹技術の1つであるSLAMを独自開発するKudan株式会社の千葉悟史さんにARの現在と未来への可能性について聞いた。

現実世界に3Dオブジェクトを配置し、誰のどのデバイスからも参照できる「ARクラウド」が注目を集めている。その発想自体は目新しいものではないが、近年モバイルデバイスに高度なAR機能が標準搭載されていることで、普及にはずみがついた。そして、それをさらにもう一歩先に進めるためのテクノロジーがSLAM(Simultaneous Localization and Mapping:空間認識技術)だ。

ARキットの課題とは

AR(拡張現実)のフレームワークであるアップルの「ARキット(ARKit)」やグーグルの「ARコア(ARCore)」の登場で、同分野に注目が集まっている。背景にあるのは、特別なハードウェアを追加しなくても、スマートフォンのOS標準機能だけで、さまざまなARコンテンツを手軽に利用できる環境が整ったという事実だ。たとえば、2017年12月にはARとGPSの機能を利用したアプリ「ポケモンGO」がARキットへの対応を果たし、出現したモンスターに近づいたり、その後ろに回りこめるようになったりするなど、その「リアリティ」の高さに驚かされたという人も多いのではないだろうか。

「ARの可能性はこの程度ではありません。何が現実で何がバーチャルなのかわからない世界が近い将来に実現します。アップルのARキットはよく考えられた機能ですが、まだまだ改善の余地があります」と語るのは、英国・ブリストルと日本を拠点に独自の空間認識技術「クダンSLAM(KudanSLAM)」を開発するKudan株式会社の千葉悟史さんだ。

そもそも、なぜARキットを利用したアプリではiPhoneの画面に出現した3Dオブジェクトを適切な位置に表示でき、自分が動いてもオブジェクトの位置が追随するのだろうか。

千葉さんによると、ARキットではカメラからの画像を用いて隙間のある空間の特徴点を捉えて「床面」として認識し、それ以降の位置推定は傾きセンサや加速度センサなど「IMU(慣性計測ユニット)」を用いてトラッキングを行っているのではないかとのこと。この方法は初期位置が異なる複数の人が同じARを共有することはできない。加えて、トラッキング精度の向上にも限界があると、千葉さんは見ている。

こうした現在のIMUベースの自己位置推定と制御の仕組みをより高度なものに置き換え、あるいは補完していくものと目されているのが「SLAM(Simultaneous Localization and Mapping)」と呼ばれる空間認識技術だ。

SLAMにおいて世界トップレベルの技術を持ち、積極的に商用化を推進しているのが、大野智弘氏が2011年に英国・ブリストルで創業し、2014年より日本との両拠点でグローバルの事業展開を行っているKudan株式会社だ。社名のKudanは、時代の変革時に出現する日本の妖怪「件(くだん)」に由来している。【URL】https://japan.kudan.eu

「人工知覚」がARを変える

さて、この聞きなれないSLAMという専門用語だが、簡単に言えばコンピュータが自分のいる空間を認識するための仕組みだ。イメージとしては、今いる部屋を見回して部屋の広さや天井の高さ、テーブルの位置やドアまでの距離などをコンピュータが“知覚”できるように3D空間のデータを作る技術と捉えてもよい。

「一般的に機械学習やディープラーニングのテクノロジーをわかりやすく解説するため、AI(人工知能)といった人間の脳の仕組みに例えて説明されることがあります。それになぞらえると、カメラやIMUは目や三半規管に例えられるでしょう。そして、SLAMはそうしたセンサからの情報を元にコンピュータが“今この場所にいる”といった認知をするための仕組みです。AIが人間の論理的思考を模した左脳に当たるとすれば、SLAMは外部の空間を認識するための右脳に当たります。AIに対してAP(人工知覚)と呼んでもよいでしょう」

コンピュータがこのSLAMによって今いる場所の推定が正しくできたならば、ロボットを特定の場所に動かしても周囲を把握し自律的に動けるようになったり、ARをその場にいるみんなで共有できるようになるという。

現在では、画像・映像から情報を処理する「コンピュータビジョン(CV)」という分野が、AIやロボット、自動運転技術などにまたがる要素技術として世界中で研究が進んでおり、中でも注目されているのがSLAMだ。同社が開発したクダンSLAMは、ステレオカメラや深度センサを備えたデプスカメラのような機材を利用しなくても通常のカメラから取得した2D画像からリアルタイムに特徴点を捉えて3Dマップを推定し、その空間内での視点の軌跡を同時に取得できるという特徴を持っている。

「SLAMの研究はアカデミックの分野では10年以上前から進められていますが、あくまで理論実証が目的のため、非常にCPUパワーを消費し、実用的なスピードで汎用的に使えるものではありません。一方でオープンソースのSLAMライブラリをベースに各社が開発しているものは精度が低いのが問題です。そこで私たちは独自にSLAMのアルゴリズムを作り直し、商用ベースで使えるSLAMのライブラリを開発しました。特徴としては非常に軽量なことで、スピードで言えばオープンソースの10倍高速、精度では約2倍つまり誤差が半分となるのです」

高次元のAR体験を実現

このクダンSLAMは、普通のカメラセンサからの映像からでも自己位置測定が可能で、高度な3Dマッピングや精度の高いトラッキングが行えることから、さまざまなデバイスに搭載することができる。利用を想定しているデバイスは、モバイルやウェアラブル以外にもロボットやドローン、自動車の車載カメラや監視カメラなど多岐に渡る。

もちろんiOSのARキットとも連係可能だ。組み合わせる方法はいくつか存在し、たとえばクダンSLAMをARキットに追加した場合、ARキットから取得した自己位置推定の情報を元に、一度訪れた場所の3Dマップにおける絶対位置を把握できるようになる。つまり、保存した3Dマップをほかのデバイスのユーザとも共有できるのだ。テーブルの上にあるコップがAさんにとってもBさんにとっても特定の場所にあるように見えるのと同じ仕組みが再現できる(つまり“現実”と同じ)のだ。また、ARキットでは、生じてしまう特徴点のズレなどを補正して、より精度の高い空間の点群データ(ポイントクラウド)を生成できるという。

あるいはARキット自体にクダンSLAMの一部をコンポーネントとして追加することで、カメラとIMUをうまく最適化でき、前述の機能に加えて特徴点を検出したりトラッキングする精度そのものを向上できるという。処理負荷も従来より低く抑え、パフォーマンスの改善も期待できそうだ。

「実際にiPhone 7でクダンSLAMを動かすデモ映像を公開しました。カメラ映像のみで、非常に高速に特徴点を検出してリアルタイムで3Dマップを生成し、カメラ(iPhone本体)が移動する軌跡もとれていることがわかると思います。ARkitではIMUをうまく利用しているので、統合することで環境安定性と精度を格段に上げることができます」

ARクラウドを超えて

ARやMR(複合現実)の将来の発展可能性に光明をもたらしたクダンSLAMだが、現在のところソフトウェアやAPIとして一般に公開しているわけではないという。

「私たちの会社はAP(人工知覚)技術の研究開発をメインとしていて、現在はハードウェアメーカー向けに組込み用ライブラリとして提供しています。その中で、半導体メーカーと協力してクダンSLAMを組み込んだCV(コンピュータビジョン)チップの開発にも取り組んでいます。さまざまなデバイスにクダンSLAMを搭載してもらうことで、それをベースに一般のARアプリやソリューション開発に使ってもらいたいと考えています。私たちは常々“コンピュータビジョン界のARMを目指している”と言っています」

クダンSLAMを利用したCVチップが普及し、そう遠くない未来にiPhoneなどに採用されたとしたら、どのような世界が訪れるのだろうか。

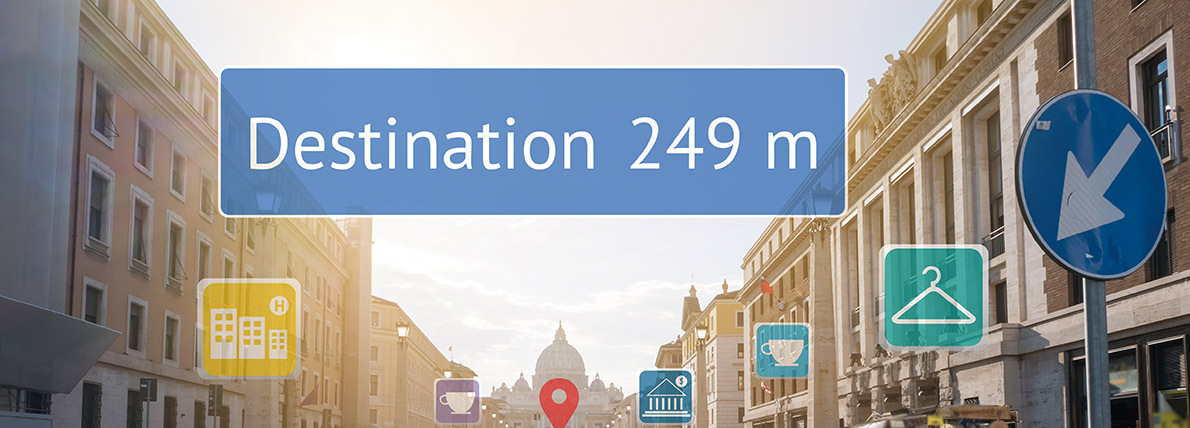

「デバイスの種類を問わず、コンピュータが共通で利用できる3Dマップの可能性は大きいと思います。今“ARクラウド”と呼ばれている動きもその1つでしょう。私たちはそのもう一歩先の世界を考えていて、モバイルカメラがリアルタイムで周囲の世界を認知できるようになれば世界がどのようになるのかをよく考えます。たとえば、街中をロボットが道案内で動き回るのは普通の光景になるでしょうし、誰かが仮想空間上に置いたものを別の人が見たり受け取ることも可能になるでしょう。また、アウトプットは画像だけに限りません。GPSが使えない屋内で道案内してくれたり、美術館を訪れるだけで音声ガイドを行ってくれることも可能になるでしょう。数年前までポスターが動くデジタルサイネージなんて受け入れられないという人もいましたが、今では日常の光景となっています。それと同じように、すべてのコンピュータが関わってくる“認知地図”が作り出すものも、自然と受け入れられていくようになると思います」

Kudanの開発した「KudanSLAM」は2D画像からリアルタイムで3Dマッピングと自己位置推定が行える。深度センサを搭載していないiPhone 7のカメラでも問題なく動作し、ARKitと組み合わせた開発も可能だ。その模様はデモ映像で確認できる。【URL】https://youtu.be/Cg6rzXbmMFk

![フリーアナウンサー・松澤ネキがアプリ開発に挑戦![設計編]【Claris FileMaker選手権 2025】](https://macfan.book.mynavi.jp/wp-content/uploads/2025/06/C5A1875_test-256x192.jpg)