AppleのAI開発の遅れがさまざまに報道されている。しかし、Appleは着々と自分たちのAI開発を進めているようだ。Appleが開発しているのは、アプリ画面のボタンなどのUIを理解するFerret-UI。

Ferret-UIが実装されれば、Siriに頼みごとをすると、あとはAIがアプリを操作してくれる”AIエージェント”の世界が拓けてくる。

Appleが求めるAIのカタチ。アプローチはこれまでと変わらず、“ユーザ側”から

大規模言語モデル(LLM)の自社開発をあきらめ、Claudeを開発したAnthropicを買収する。また、ChatGPTを開発したOpenAIと提携をするのではないか、などAppleを巡るさまざまな報道がされている。つまりは、「自分では作れないので他人に頼る」ということで、Appleの技術力の低下を指摘する記事が多い。

ただし、この議論にはひとつの視点が抜け落ちている。それはAppleのものづくりへの考え方だ。Appleはまず、ユーザがデバイスをどのように使うのかを想像する。そして、それを実現するソフトウェアを開発し、そのソフトウェアが動作するハードウェアを設計する。ユーザ側から発想していくのだ。

この考え方からすると、LLMは必要だが、推論能力を競い合うレースに参加するようなLLMは必要としていない。Appleが求めているのは、スペックの高いAIではなく、ユーザの心に響くAIなのだ。

では、それが具体的にどんなものなのかというと議論は定まらない。あくまで個人的な想像だが、「AppleはどのようなLLMが必要なのか」という点で意見が集約できないのではないだろうか。そのため、定評のある他社開発のLLMを採用するというのは、当然、考えられる選択肢のひとつになる。

デバイスに組み込むべきは、いわゆる“生成AI”ではなくAIエージェント

生成AIというと、深い推論能力でテーマを指示するとビジネスレポートを仕上げてくれるものだとか、仕様を伝えるとプログラミングコードを出力してくれものなどが話題になる。しかし、このようなAIをiPhoneなどのデバイスに組み込む必要はない。Webや専用アプリで使えればいいからだ。

デバイスに組み込むべきAIは、AIエージェントである。何かを指示すると、あとはAIが判断してアプリを操作し、実行をしてくれるというものだ。

たとえば、「◯月×日、1泊で大阪出張をするので、手配をお願い」と音声やテキストで伝えると、新幹線アプリを起動して座席を予約し、ホテルの予約アプリを起動し部屋をとってくれる。途中で細かい時刻や場所などの確認はするものの、指示をすればすべてやってくれるというのがAIエージェントだ。すでにファーウェイなどの中国スマホメーカーは、初歩的な機能を搭載し始めている。

「Ferret-UI」。Appleが開発する“UIを理解するAI”

ところが、AIにとってアプリの操作は難易度が高い。特にフラットデザインになってからは、ボタンというものが少なくなり、画像やテキストがボタンになってきている。

どの画像はタップ可能で、どの画像はタップできないのか。私たちは試行錯誤で学習をし、文脈から「この画像はタップできる」と判断しているが、これを予備知識ゼロのAIに正確に行わせることは簡単ではない。小さな子どもにAppleデバイスを渡すと、最初は画面のあらゆるものをタップするようになる。それと同じで、AIにも試行錯誤をさせて学習させる必要がある。

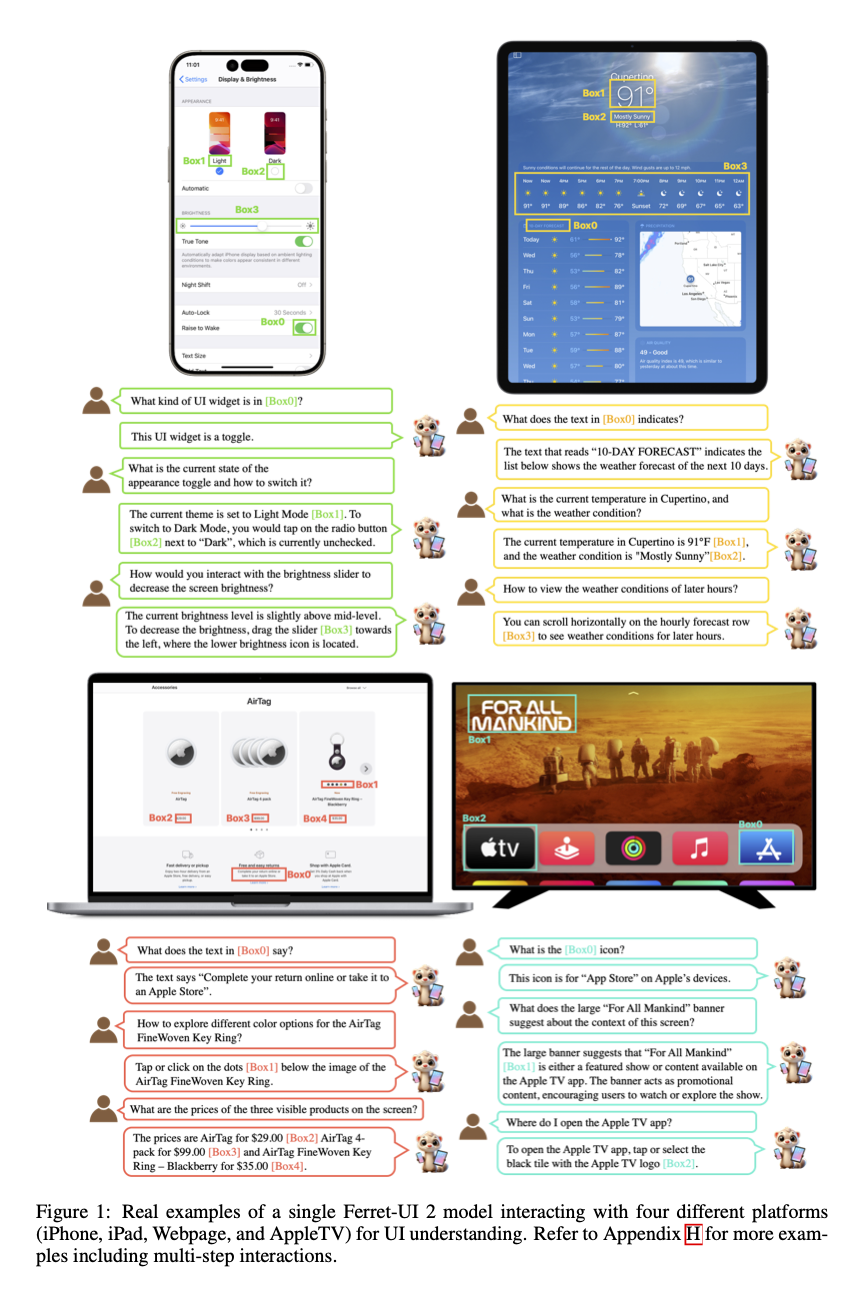

Appleは、このUIを理解するAIを開発している。それがFerret-UIと呼ばれるもので、次世代のFerret-UI 2では、iPhoneだけでなく、iPadやWebサイト、Apple TVなどのUIも理解できるようになっている。

UIを理解するAIはFerret-UI以外にも。3つのテストから見える実力

現在、このようなUIを理解するAIは、AppleのFerret-UI以外にもさまざまある。有名なのは、視覚情報も理解できるマルチモーダルAI「GPT-4V」(OpenAI)だ。このほか、米Adept AIが開発した「Fuyu」がある。

また、中国清華大学とZhipuAIが共同開発した「CogAgent」は、Ferret-UIと同じくUIの理解に特化しているため強力なライバルだ。

Appleは、この4つのAIにアプリ画面を見せ、どのように理解したかを論文「Ferret-UI: Grounded Mobile UI Understanding with Multimodal LLMs」で紹介している。

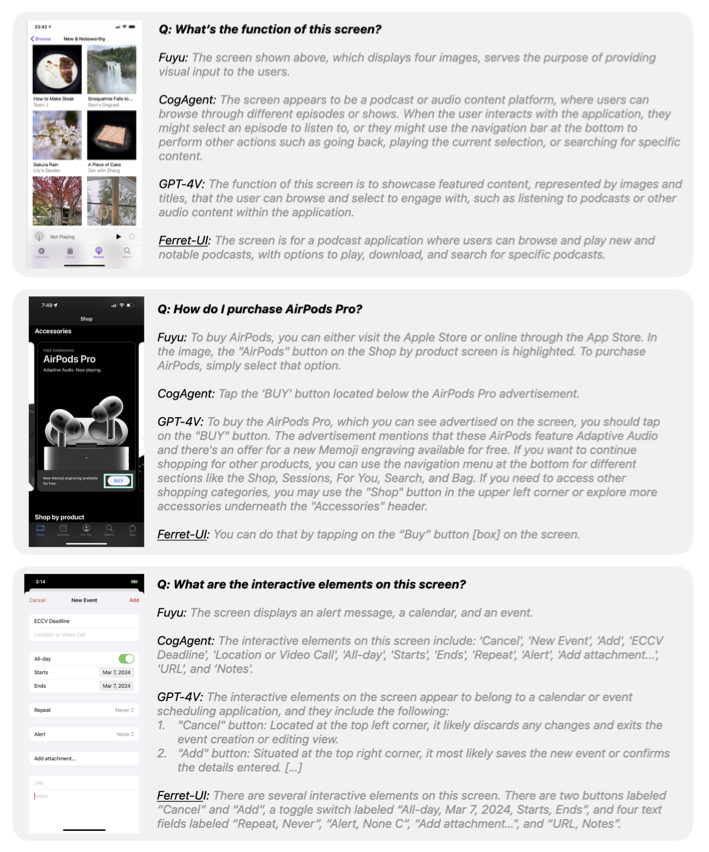

テスト①:ポッドキャストアプリの新着画面を見せ、「この画面の機能は?」と質問した場合

・Fuyuの回答

この画面は4つの画像を表示していて、ユーザに視覚的入力を提供しています。

・CogAgentの回答

この画面は、ポッドキャストまたは音声コンテンツのプラットフォームです。ユーザは、さまざまなエピソードや番組を閲覧することができます。ユーザが操作を行うには、聞きたいエピソードを選んだり、下にあるナビゲーションバーで逆戻しをしたり、選択した箇所を再生したり、特定のコンテンツを選択することができます。

・GPT-4Vの回答

この画面の機能は、推薦コンテンツの提示で、画像とタイトルで構成されています。そこで閲覧をし、気になる項目を選び、ポッドキャストを聞いたり、アプリの中にある別の音声コンテンツを選んだりすることができます。

・Ferret-UIの回答

この画面はポッドキャストアプリで、ユーザは新着やおすすめのポッドキャストを選んで再生することができます。また、再生、ダウンロード、特定のポッドキャストを検索する機能もあります。

テスト②:「Apple Store」アプリのAirPods Proの購入ページを見せ、「AirPods Proを購入するにはどうすればいいのか」と質問した場合

・Fuyuの回答

AirPodsを購入するには、Apple Storeに行くか、オンラインのApple Storeを使ってください。画像では、ショップの「AirPods」ボタンが強調表示されています。AirPodsを購入するには、ボタンをクリックします。

・CogAgentの回答

AirPods Proの広告の下にある「購入」ボタンをタップします。

・GPT-4Vの回答

画面の広告で見ているAirPods Proを買うには、「購入」ボタンをタップします。広告はAirPodsがアダプティブオーディオの機能を持っていることが強調され、新しいミー文字を無料で彫刻できる提案もあります。他の製品を購入するために買い物を続ける場合は、下部のナビゲーションメニューを使い、「製品」「学び」「For You」「検索」「バッグ」などに移動できます。ほかの場所に移動をするには、左上にある「製品」ボタンを使うことができ、「アクセサリ」ヘッダの下からほかのアクセサリを見ることができます。

・Ferret-UIの回答

画面のボックスで囲まれた「購入」ボタンをタップすることで購入できます。

テスト③:カレンダーの設定ボタンを見せ、「この画面で操作できる要素はどれですか」と質問した場合

・Fuyuの回答

画面は、アラートメッセージ、カレンダー、イベントを表示しています。

・CogAgentの回答

この画面の操作できる要素は「キャンセル」「新規イベント」「追加」「ECCVデッドライン」「場所またはビデオ通話」「終日」「開始」「終了」「繰り返し」「通知」「添付ファイルを追加」「URL」「メモ」です。

・GPT-4Vの回答

この画面の操作できる要素は、カレンダーまたはイベントスケジュールアプリのもので、以下のものがあります。

(1)「キャンセル」ボタン。上部左隅にあり、すべての変更を無視し、イベント作成画面や編集モードから出ることができます。

(2)「追加」ボタン。上部右隅にあり、新しいイベントを保存したり、入力した詳細を確定することができます。

・Ferret-UIの回答

この画面にはいくつかの操作できる要素があります。「キャンセル」「追加」トラベルされた2つのボタンのほか、「終日」トラベルされたトグルスイッチ、「2024/03/07」とラベルされた開始、終了、さらには「繰り返し、しない」「通知、なし」「添付ファイルを追加」「URL、メモ」の4つのテキストフィールドがあります。

Ferret-UIの行き着く先は「ナレッジナビゲーター」。Appleが1987年に公開した未来のコンセプト

3つのテスト結果を記載したが、いかがだろうか。Ferret-UIは、画面の要素を的確に捉えていることがわかるはずだ。ほかのAIに比べ、過不足なく答えている。つまり、アプリ画面の操作体系を理解しているのだ。

今後、iPhoneはAIエージェントのように進化していくと考えられる。「ヘイSiri! 8月20日から1泊の大阪出張がある。手配をお願い」と言えば、時々、「目的地は大阪市のxx社ですか」「目的地の近くにホテルを取りますか」などと聞いてきて、回答に応じてホテルと新幹線のチケットをウォレットに追加し、カレンダーに日程を登録してくれる。

このような話を聞いて、古くからのAppleファンはあることを思い出すだろう。1987年にAppleが公開したナレッジナビゲーター(Knowledge Navigator)だ。

音声でやりとりができる対話型エージェントで、公開された映像の中では大学教授の秘書と研究助手を務めている。当時のジョン・スカリーCEOがコンセプトマシンとして提案したもので、Macが21世紀までに目指す形だと誰もが考えた。

「Appleのさまざまな技術はすべてはナレッジナビゲーターの実現のために開発されてきた」と言う人までいるほどで、今でもAppleデバイスの世界では重要なコンセプトモデルになっている。

Appleは“AIエージェント開発”では先頭を走っている? 今後、より重要視されるプライバシー保護

Appleデバイスは、AIエージェントあるいはナレッジナビゲーターの実現に向けて、もうひとつ有利な点がある。それはプライバシーの扱いだ。

たとえば目の前にクッキーがあり、それをデバイスに見せたとき、私たちはこう答えてほしい。「これはxx社のクッキーで、45kcalあります。本日のあなたの食事から考えると、3枚まで食べても健康に悪い影響はありません。ただし、あなたには小麦アレルギーの傾向があるので、2枚までにしておくことをおすすめします」。

つまり、デバイスには一般的な回答をするだけではなく、自分に特化した回答をしてほしい。そのためには、AIが利用者のプライバシーを把握しておかなければならない。これはある意味、怖いことかもしれず、ジョージ・オーウェルの「1984」の世界が現実味を帯びてくるかもしれない。

ところが、ご存じのとおりAppleデバイスは利用者のプライバシー情報をデバイスの中にとどめ、外部に送信しない。Appleが収集するときも、断片化したり匿名化したりして、統計情報は取れるが、どれが誰のデータなのかは確認ができない形にする。そのため、私たちは安心してAppleデバイスにプライバシー情報を渡せるのだ。

今後、現状のAIがAIエージェント化して、個人生活の中に入り始めると「プライバシーの収集」が必ず大きな課題になっていく。そういう意味ではAppleは、LLM開発には出遅れたが、AIエージェント開発には最短距離にいるのかもしれない。

おすすめの記事

著者プロフィール

牧野武文

フリーライター/ITジャーナリスト。ITビジネスやテクノロジーについて、消費者や生活者の視点からやさしく解説することに定評がある。IT関連書を中心に「玩具」「ゲーム」「文学」など、さまざまなジャンルの書籍を幅広く執筆。